img- generata da IA dominio pubblico

Intervista a Enrico Panai di M. Minetti

Enrico Panai è specialista di interazione uomo-informazione e un ricercatore indipendente in cyber-geografia e etica dell’informazione. Ha insegnato informatica umanistica presso il dipartimento di filosofia dell’Università di Sassari. Dal 2007 vive e lavora in Francia. Dal 2018 collabora con il dipartimento di scienze umanistiche e sociali dell’Università di Sassari. Direttore Generale dell’azienda di consulenza SARDUS FRANCE/ BEETHICAL.

(i molti refusi sono dovuti all’uso fiducioso di intelligenza artificiale per la trascrizione dell’intervista)

MM: Quando i sistemi di intelligenza artificiale non hanno bisogno del controllo umano e quindi prendono decisioni che hanno un impatto etico?

EP: In tutte le tecnologie che hanno capacità di agire creano una situazione morale nel quale hanno un impatto etico. Questo può essere uno stadio di neutralità o di inerzia, quindi puoi negligere le conseguenze etiche, e questo è nella maggior parte dei casi, mentre esistono dei rischi etici tutte le volte in cui i sistemi di intelligenza artificiale sono lasciati da soli senza quello che viene chiamato Human oversight, supervisione umana.

MM: Io volevo proprio chiederti quali sono i campi in cui l’intelligenza artificiale agisce, cioè che vuol dire “agisce”? In quali campi effettivamente opera autonomamente, in questo momento? Ora per esempio mi viene in mente che un campo potrebbe essere il trading algoritmico, in cui il sistema attua transazioni direttamente, senza controllo umano.

EP: In quasi tutti i campi. La statistica, ad esempio, si è evoluta con l’intelligenza artificiale. Sono pochi quelli che fanno statistica pura oggi, la maggior parte utilizza modelli di intelligenza artificiale per fare previsioni. E quelle previsioni producono azioni. Ti faccio un esempio. In campo militare ci sono decisioni che hanno un oversight umano, quindi una decisione umana e poi applicazioni che non hanno controllo umano: alcune azioni dei droni militari non hanno un oversight umano. Agiscono perché hanno una missione e ci creano grandi problemi etici. La stessa cosa avviene per i sistemi economici. Lo stesso freno automatico di una macchina, il correttore di guida di una automobile funziona con dei sistemi, a volte basati intelligenza artificiale, che fanno la correzione della guida in tempo reale perché i loro sensori esterni inviano dei messaggi che vengono interpretati da un’unità centrale, in cui è in cui è installato un modello, generalmente di Deep Learning, che permette di fare un’interpretazione di quello che sta vedendo. Tutte le macchine che vogliono essere autonome e stiamo parlando del parcheggio di una macchina. Il parcheggio automatico di una macchina funziona usando vari sensori, alcuni visivi, altri a ultrasuoni, altri sono dei veri e propri radar, li mette assieme e crea il percorso giusto per fare il parcheggio usando dei sistemi di intelligenza artificiale che sono imbarcati all’interno di un processore, l’unità centrale dell’automobile.

MM: Il parcheggio della macchina è un ottimo esempio, la macchina può investire un pedone o un ciclista, però più inquietante è il campo militare. Tu mi dicevi che esistono droni armati che partono per la missione e non hanno più un controllo umano, quelli sparano quando decidono di sparare. Oppure nel trading finanziario, la macchina compra azioni perché quelle azioni stanno avendo quel certo comportamento e secondo quel modello quelle azioni saliranno di prezzo.

EP: Ho lavorato un po’ sui droni, poi ci sono le automobili le automobili, l’industria quindi delle macchine, le Smart Cities che utilizzano i sistemi di gestione del traffico in maniera automatizzata, la gestione della circolazione su rotaie, la la finanza come hai detto tu prima, esistono alcuni sistemi militari, esistono i semplici social network. la sequenza di raccomandazioni di un social network mi caccia qualcuno che ti mette la sequenza sono tutti i sistemi automatizzati e visto che sono miliardi di informazioni al secondo non c’è nessuno che fa una verifica umana di quello che tu vedrai o della sequenza di informazioni che hai e ognuno di questi sistemi ha dei rischi diversi. Vai dal rischio della vita a dei rischi di semplice fastidio nel fare una pratica quindi i rischi sono di tutti i livelli Guarda questa bottiglia di latta. Sino all’altro giorno era era saldata e prodotta con un sistema software che calcolava le possibilità di errore nel farlo. Oggi hai dei sistemi dei sistemi visivi che guardano i bordi della saldatura e ne analizzano la qualità. Quindi c’è un sistema di intelligenza artificiale anche per fare questa borraccia di acciaio. Quando dico che sono un po’ dappertutto, nel nell’analisi dell’acqua che bevi quotidianamente ci sono sistemi di intelligenza artificiale, perché uno pensa solo per esempio all’ambito medico e là c’è un problema ancora maggiore perché in quello che viene chiamato il framework unificato dei clienti etici i principi sono benevolenza e non malevolenza, due dei principi fondamentali. Quando tu in campo medico non utilizzi un sistema che potrebbe a salvare delle vite e hai paura di utilizzarlo perché usa intelligenza artificiale, stai avendo un comportamento non etico. E’come dire io ho una buona medicina ma non lo uso perché io non mi fido. Ho un buon vaccino ma non lo uso perché non mi fido dei vaccini anche se ho le prove che possono salvare vite umane. Nel campo medico abbiamo avuto l’effetto contrario Per prudenza a volte abbiamo evitato di fare delle scelte positive che potevano essere dimostrate scientificamente come positive. Quindi, come ti dicevo, l’IA è dappertutto. Si possono stare ore e ore a elencarne gli attuali utilizzi.

MM: Quindi un po’ chi se ne frega di GPT-4. Insomma mi sembrava importante chiarire quali sono i rischi dei chatbot. C’erano i valori di trasparenza, libertà di scelta, benevolenza e non maleficenza. Vuol dire tutto e non vuol dire niente. Certo nessuno vuole una IA cattiva di proposito. Però come fa l’intelligenza artificiale a capire se quello che sta dicendo non è maleficente? Tipo: -Ok Google, Alexa, Siri..voglio una sfida! E quella risponde: -Bevi dell’acido muriatico! Vediamo se ne hai il coraggio! E’ un caso limite ma potrebbe portarti a fare cose che non vorresti. Cosa sono i nudge? Non so se si dice così o la teoria dei nudge, ho visto vuol dire pungolo. Quindi è una tecnica per influenzare le scelte. Quindi: cosa sono i nudge in ambito di piattaforme e come coinvolgono scelte paternalistiche o etiche? E che differenza c’è fra i nudge semplici o implementati con l’intelligenza artificiale, quindi solo di design o di programmazione o appunto se potenziati dall’IA? Parlavi appunto dell’algoritmo di visualizzazione delle notizie nei social network…

EP: I nudges sono fondamentalmente delle spinte gentili. Cioè non c’è una forzatura e non c’è un lavoro subliminale. E’ bene fare questa distinzione dal punto di vista scientifico. Da un punto di vista pratico influenzano la maggior parte degli utenti nel prendere una decisione. Per un’azienda non è importante che riesca a influenzare tutti ma che riesca a indirizzare verso una decisione pittosto che un’altra, la maggior parte della popolazione che sta operando una scelta. Diciamo che sono sempre esistiti : per esempio il cavallo di Troia era un grande nudge perché ti metto il cavallo davanti alla porta e nessuno ti obbliga a portarlo dentro, però lavora su dei meccanismi psicologici che ti che sono quelli della curiosità e della paura di perdere qualcosa e che ti dicono no non dobbiamo portare dentro altrimenti gli dei non saranno contenti deve essere un messaggio di divino eccetera… quindi lavora su queste paure, il nudge classico. Con la tecnologia del digitale i nudge sono stati traslati a livello digitale per fare degli esempi se tu vai sulle pagina web di una compagnia aerea low cost Troverai dei pulsanti che sono più visibili di altri. I pulsanti dove devi acquistare sono hanno colori accesi gli altri hanno colori , come dire spenti, hanno dei grigi. Oppure alcuni pulsanti sono più grandi altri più piccoli Questa è la legge di Fitts che è conosciuta in in user design e user interface design perché praticamente più è grande il pulsante, più facile cliccarci. Però considera che la stessa tecnica che usava Hitler per votare: vedervi la scheda elettorale, c’era: “lo vuoi Hitler ?” Sì era enorme, No era piccolino, cioè non è una novità È solo una traslazione digitale di quello che avviene da sempre. Con intelligenza artificiale è qualcosa di più. Finché usavi un nudge singolo per fare un’azione era semplice identificarlo e studiarne l’effetto. Quando tu usi sequenze di nudge, cioè piccoli modifiche che sono messe in un ordine tale che ti portino a fare qualcosa, allora l’impatto è poco conosciuto ancora, perché si arriva a moltiplicatori dalle possibilità molto alte per cui studiare gli effetti possibili è difficilissimo. La sequenza di nudge funziona, sai quando i giochini dei bambini che dicono: “Ripeti cinque volte la parola x e io ti dirò che a che colore stai pensando?” Funziona un po’ in questo modo. Quindi i sistemi di intelligenza artificiale riescono a trovare questi errori sequenziali nelle persone, a personalizzarli per spingerti a prendere una decisione che il produttore vuole, anche un po’ contro la tua volontà di base. Perché in realtà stai lavorando sulla stanchezza e su dei bias cognitivi. Poi esistono dei nudge, prodotti da intelligenza artificiale, che sono sottilissimi e riguardano il cambiamento di variabili quasi impercettibili. Non stiamo ancora parlando di subliminale, però il cambiamento di alcune variabili spinge a cambiare un comportamento. Questo può essere il tono della voce, ad esempio, io scopro che Matteo è più reattivo a dei toni gravi invece che dei toni acuti, nella mia interfaccia di comunicazione abbasso di un tono, una mezza tonalità la voce, oppure la alzo di una mezza tonalità o di due sono quasi impercettibili se non hai l’orecchio assoluto, però nel lungo termine ti fanno cambiare comportamento.

MM: Ma questa cosa fa parte dei meccanismi di seduzione, di un potenziamento di meccanismi di seduzione e convincimento. Ma qand’è che questo coinvolge l’etica? Per esempio quando coinvolge su una campagna politica? Quando il nudge spinge verso scelte politiche che hanno degli influssi sulla vita di tutti? Quando porta verso narrazioni utili al controllo sociale, al consenso e all’obbedienza?

EP: L’etica è sempre coinvolta. In questo caso è un’etica pubblica quando i nudge vengono utilizzati dai governi in maniera paternalistica. Per cui hai un problema di etica pubblica, per cui il dibattito deve essere aperto. Dalla presidenza Obama negli USA abbiamo iniziato a avere società che utilizzano i nudge per convincere grandi masse di persone a far qualcosa. In Inghilterra c’è una società che si occupa di questo, che è stata creata dal governo poi è diventata privata. In Francia ci sono delle società che hanno fatto questo. Un po’ dappertutto nel mondo si creano queste società che cercano di portare a un comportamento diverso grandi masse di persone con un approccio paternalistico. C’è un grande dibattito da questo punto di vista, perché a sviluppare la teoria dei nudge sono stati uno psicologo e un economista, quindi l’approccio era più dal punto di vista paternalista. L’intenzione era creare dei meccanismi che migliorino il benessere delle persone, ad esempio facendole camminare di più, così stanno meglio di salute, riducendo le emissioni di CO2, perché li incentiviamo a prendere la bicicletta eccetera .. questi però sono nudge fisici o digitali abbastanza semplici da identificare. I nudge con l’intelligenza artificiale sono molto più difficili da identificare. Anzi a volte vedi solo gli effetti ma non le cause, perché identificare la sequenza di cause è quasi impossibile. Però hanno degli effetti materiali, altrimenti le persone non passerebbero ore su YouTube. Quando vedi un ragazzino, o un adulto, che passa ore su YouTube non puoi dargli la colpa perché in realtà è, in un certo modo, manipolato dalla sequenza di informazioni che ha a disposizione. Sono convinto e ci sono degli Studi che mostrano bene questo, che se tu prendi un filo di informazioni che interessano a te e lo dai a me, io non lo seguo. Dopo un po’ mi stanco di vedere i video che interessano a te o tu ti stanchi di vedere i video che interessano a me. Quindi vuol dire che c’è veramente un lavoro di personalizzazione sulla reazione comportamentale delle persone. Quindi i nudge possono essere negativi per questo. Allo stesso tempo, per categorie deboli, anziani, persone con handicap, i nudge potrebbero essere un elemento fondamentale. per esempio delle persone che soffrono di Alzheimer hanno dei processi di immagini e che le aiutano nel momento giusto a ricordare qualcosa quindi in realtà rendono la loro vita Quasi normale per cui non possono essere condannati senza la valutazione del campo devono essere utilizzati con grano salis.

MM: Ok passiamo alla terza domanda. Chi è che nelle aziende, che siano appunto istituzionali pubbliche o più spesso agenti privati, che decide i valori etici da implementare e di solito di che tipo sono?

EP: Allora esistono alcuni valori etici che sono riconosciuti dalla carta dei diritti dell’uomo, che è uno dei margini nei quali ci si muove generalmente nel mondo occidentale e non solo nel senso che anche in tutto il mondo vengono almeno formalmente accettati. Dopodiché ci sono dei valori che sono molto localizzati per esempio, in Europa, la Comunità Europea ha degli specifici valori che sono, non sulla persona, ma sulla relazione. Per esempio il valore di democrazia. Il valore di democrazia deve essere difeso dalla comunità europea e se lo difendi devi combattere le fake news. Non perché la loro natura non è vera, ma perché impattano la relazione tra le persone: se hai due persone che hanno frequenze diverse il livello comunicativo Tra queste persone si abbassa e per cui il dialogo sociale e democratico non può svilupparsi e quindi c’è un rischio Democratico per cui esistono già dei valori. Poi, e sarò completamente onesto con te, moltissime aziende fanno hanno un errore sistemico che è quello dell’ethics shopping, che è un po’ come il cherry picking in nella scienza, nel senso che ci sono centinaia di principi e valori etici che circolano nel mondo e loro ne prendono un po’: i tre o quattro che gli interessano. Li mettono in una carta etica e dicono, noi rispetteremo questi valori sapendo che la carta etica è importante ma non ci si può fermare alla carta etica. Se scrivi una carta etica non è detto che stai applicando davvero quei valori. Come la Repubblica Democratica Tedesca, non era poi tanto democratica. Era una repubblica dell’est sotto controllo sovietico. Non puoi definirla democratica in se stessa, però aveva il nome Democratica nel titolo. la stessa cosa avviene per i principi che sono stati comprati e messi un po’ assieme. La maggior parte delle volte vengono identificati alcuni principi, alcuni valori e comunicati al mondo. Molto raramente si prendono decisioni etiche in maniera esplicita all’interno dell’azienda. Cioè i comitati etici che hanno un processo trasparente di presa delle decisioni sono rari e sono sempre oscuri. Mentre una decisione etica dovrebbe essere: ho un problema, identifico il tipo di problema e il tipo di possibile soluzione. Perché tu hai problemi etici che possono essere binari: sì o no, o sfaccettati, che possono avere più soluzioni, quindi una scala di grigi, e lì devi prendere una decisione etica sulla soglia. Poi hai i dilemmi, di cui molti pseudo-eticisti spesso ti parlano. Perché un dilemma si chiama dilemma proprio perché non può essere risolto. Il famoso dilemma del trolley. Problema: con il treno ammazzi cinque persone o una? L’automobile deve prima uccidere il bambino o il vecchio? Quando senti persone che portano loro risposte assolute stanno dicendo il falso. Nel senso che dipende dalla situazione, perché se l’anziano è tuo padre e il bambino non lo conosci.. Uccidi il bambino. Quindi è anche stupido rispondere. Per rispondere alla tua domanda. Nell’azienda spesso vengono costituiti dei comitati etici che però fanno semplicemente dell’ethics washing. Fanno ethics shopping per poi pubblicarlo nella comunicazione commerciale come forma di marketing. L’etica la potresti applicare quasi senza pubblicare sul tuo sito Internet che stai facendo etica, perché è come in un giardinetto pubblico. Dà più sicurezza avere dei militari armati col mitra, oppure avere dei bambini che giocano? La sicurezza non te la danno i militari armati col mitra, la sicurezza te la daranno i bambini che giocano. E’la stessa cosa con l’etica. L’etica funziona se non la vedi quasi. Come diceva Calvino, è leggera e trasparente. Allora sta funzionando Se invece me lo devi dire ad ogni istante, probabilmente c’è un problema di applicazione etica, altrimenti non avresti bisogno di dirlo.

MM: Come la pubblicità delle banche, sempre carica di valori etici, quando poi sono praticamente degli strozzini.. La domanda era anche quella su chi, all’interno di queste aziende, decide quali valori sono ritenuti importanti, anche fosse uno shopping etico. Chi è nell’azienda che decide? E’ la proprietà, la direzione o sono degli esperti?

EP: Dipende dalle aziende. Comunque è una scelta che è in capo alla .direzione ma non sempre coscientemente, nel senso che intanto hai etiche diverse, che diventano vari punti di pressione all’interno di un’azienda, e dai principi etici che arrivano da altri punti dell’azienda. Per esempio l’etica degli affari è un’ etica di altro livello che si occupa grosso modo del rapporto dell’azienda con l’esterno e dei rapporti interni all’organizzazione: cioè l’azienda non deve inquinare, all’interno dell’azienda ci deve essere una una eguaglianza di generi nel trattamento del personale…si occupa di queste cose. L’etica dei digitale si occupa di tutto il processo di digitalizzazione del reale, quindi qualsiasi cosa che viene digitalizzata quindi trasformata in dati. I dati vengono trattati e diventano un output che produce una decisione. Tutto questo processo generalmente viene indicato dall’etica del digitale, che però è molto nuova, quindi sono venuti a occupare quello spazio anche persone con competenze che erano al limite. Spesso ingegneri. Dato che stai parlando di etica del digitale esistono alcuni principi che sono in altri settori. C’è chi si occupa di Cyber Security si sta per l’etica cardio digitale se tu vivi nel digitale puoi morire di digitale per cui la prima cosa è sicurizzare il digitale se no non puoi fare etica, non puoi fare nient’altro. Quindi in realtà chi si occupa di GDPR, di protezione dei dati personali, si occupa di un principio che può essere considerato un principio etico. La privacy dell’utente digitale per cui esistono principi che, come dire, passeggiano nell’industria in vari aspetti. In nessuna azienda che io abbia incontrato finora c’è mai un organo decisionale assoluto, nel senso che funziona per un equilibrio tra desideri personali, visioni di impresa, pura casualità e quindi non c’è mai una persona specifica che lo fa e anche quando ci sono delle truppe di persone, c’è una negoziazione. Spesso chiamano esterni per farlo perché così dicono, vabbè l’hanno fatto degli esperti, noi non ci abbiamo messo le mani e adesso continuiamo a fare il business As usual, come si dice.

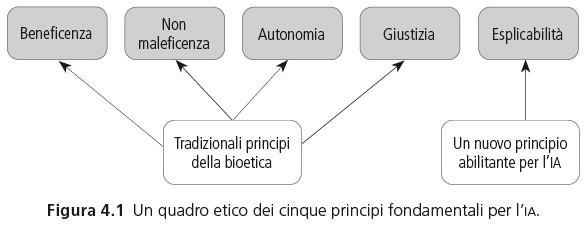

MM: Quali sono i principali valori etici e utilizzati nell’intelligenza artificiale che vengono applicati o che si cerca o che si vorrebbero applicare all’intelligenza artificiale? EP: Allora esiste un articolo di Jobin e altri che aveva classificato centinaia di principi etici che sono utilizzati nell’intelligenza artificiale. In realtà qualche tempo dopo Floridi con la sua equipe hanno lavorato su su cinque principi di base che sono il principio di benevolenza di non maleficenza (dall’inglese) di autonomia, di giustizia. Questi sono principi che vengono dalla bioetica e lui ne ha aggiunto un altro che è l’esplicabilità. Ora l’espicabilità in un concetto che ne racchiude due all’interno. Uno è quello relativo alla intelligibilità di qualcosa. La capacità di capire cosa ci sia dietro a un sistema che sta funzionando ed è fondamentale per rassicurare una persona su come sta funzionando il sistema ma allo stesso tempo per dare un livello di responsabilità morale. Se so come funziona so chi a che punto devo dare la responsabilità al sistema perché un sistema è una pipeline complessa, raramente le aziende hanno un solo sistema. Prendi le macchine autonome. Hanno vari fornitori che forniscono vari elementi e ognuno funziona con sistema di IA. quindi devi metterli in collaborazione quindi capire quale è responsabile è fondamentale. Devi saper leggere come funziona il sistema. Bisogna stare attenti perché se io fossi un fisico ti potrei parlare per formule fisiche Ok non è detto che tu che hai studiato filosofia , ma anch’io ho studiato filosofia però per noi lo capiamo Ok però un fisico ci parla per formule fisiche per lui è comprensibilissimo ma non è intellegibile per noi, ed è giustissimo quello che sta dicendo. Quindi il livello di intelligibilità è veramente relativo alla persona che lavora sul sistema.  Questi sono cinque principi unificati prendono un po’ tutto quanto. Alcuni sono complessi come quello di giustizia. Cosa voglia dire giustizia in un output di un sistema di intelligenza artificiale è molto relativo. A volte ci sono delle prese di posizione che possono essere avaguardiste oppure retrograde oppure solamente allinearsi allo status quo, quindi dipende dall’azienda ogni scelta ha un pro e contro: economicamente e eticamente. Assumere più più uomini che donne come sviluppatori probabilmente riflette una certa coerenza nel rapporto che c’è con il reale. Nel senso che nel mondo dell’offerta di lavoro ha un rapporto diretto con la demografia però nella categoria degli sviluppatori sono più gli uomini che le donne. Però per sviluppare sistemi di IA è più interessante avere un equilibrio tra uomini e donne. Perché le donne riusciranno a mitigare i rischi di discriminazioni di genere perché avranno più attenzione nel rilevare aspetti di sessismo. Se tu hai delle equipe che sono più o meno equilibrate però avrai un abbassamento qualitativo per esempio dell’equipe, perché statisticamente visto che stai prendendo più donne, e ce ne sono di meno, dovrai abbassare il livello di competenza professionale richiesta.

Questi sono cinque principi unificati prendono un po’ tutto quanto. Alcuni sono complessi come quello di giustizia. Cosa voglia dire giustizia in un output di un sistema di intelligenza artificiale è molto relativo. A volte ci sono delle prese di posizione che possono essere avaguardiste oppure retrograde oppure solamente allinearsi allo status quo, quindi dipende dall’azienda ogni scelta ha un pro e contro: economicamente e eticamente. Assumere più più uomini che donne come sviluppatori probabilmente riflette una certa coerenza nel rapporto che c’è con il reale. Nel senso che nel mondo dell’offerta di lavoro ha un rapporto diretto con la demografia però nella categoria degli sviluppatori sono più gli uomini che le donne. Però per sviluppare sistemi di IA è più interessante avere un equilibrio tra uomini e donne. Perché le donne riusciranno a mitigare i rischi di discriminazioni di genere perché avranno più attenzione nel rilevare aspetti di sessismo. Se tu hai delle equipe che sono più o meno equilibrate però avrai un abbassamento qualitativo per esempio dell’equipe, perché statisticamente visto che stai prendendo più donne, e ce ne sono di meno, dovrai abbassare il livello di competenza professionale richiesta.

MM: Mi stai dicendo, di fatto, che se tu inserisci in uno staff che sviluppa intelligenza artificiale diciamo un gruppo misto con più minoranze o comunque con una parità di genere e di origini, cioè che ingloba delle differenze maggiori, in un certo senso, il sistema che viene prodotto ha incorporato una tutela delle differenze perché è come se fosse figlio di una famiglia arcobaleno?

EP: Non il sistema ma i suoi meccanismi di mitigazione. Nel senso che se tu hai meccanismi di controllo, chiamiamoli anche così, in realtà si chiamano meccanismi di mitigazione del rischio e saranno migliori perché hai più occhi che vedono degli elementi che non sono visibili dagli altri, è veramente banale.

MM : Sì infatti è come se ti trovi in un ambiente solo di uomini, la battuta sessista non viene magari condannata come se sei in un ambiente misto. Cosa è che reprime la battuta sessista? Un meccanismo di controllo, di autocontrollo che ti dice questa cosa non è giusta. Quindi in un certo senso chi sviluppa, non il sistema ma i meccanismi di controllo, ne stabilisce le regole etiche. Cioè l’eticità del sistema è data dalla composizione anche umana delle persone che collaborano costruire questo sistema.

EP: Ho difficoltà a parlare di eticità del sistema. da un punto di vista formale si dice che la tecnologia non è etica. L’uso che se ne fa ha implicazioni etiche.

MM: E noi sappiamo che l’etica non è una ma sono tante, storicamente determinate, quindi è una valutazione Nel senso che però possiamo descriverle. Questo riguarda i valori etici che noi possiamo avere. Non so se nel libro di Floridi, mi sembra che anche lì, in un certo senso, quei cinque principi (1) che vengono nominati fanno parte di una di una etica utilitarista, che riguarda una libertà di tipo formale. Cioè che intende informare gli agenti umani e basarsi sulla loro autonomia della scelta. Come se gli agenti umani potessero realmente conoscere e interpretare il perché delle loro scelte, cosa che è molto dubbia. L’autonomia è la base del liberismo classico cioè presupponiamo che esista la libertà di scelta e la libertà, diciamo, di non essere influenzati o costretti ad una scelta. Però questa è una libertà puramente formale. La libertà sostanziale è garantire che tutti siano in grado di compiere quella scelta in autonomia, liberi dal bisogno e dal ricatto. Il che è un obiettivo molto elevato ma può essere considerato solo come un orizzonte a cui tendere, a cui è impossibile arrivare nei fatti. La democrazia liberale si basa su questi valori ma è stato dimostrato in tutto il Novecento, e tu hai fatto anche molti esempi, che le scelte umane non sono affatto basate su un agente razionale. Anzi, forse per definizione, una scelta etica é necessariamente irrazionale.

EP: Bisognerebbe che lo capissero i molti ingegneri che vogliono fare imbarcare l’etica sui sistemi. Cosa che, secondo me e secondo molti pensatori, è assolutamente impossibile da fare. Perché è proprio uno sbaglio concettuale imbarcare l’etica, perché io posso prendere una decisione oggi essendo la stessa persona quindi avendo un’etica della virtù identica, stessa formazione, posso fare una scelta oggi, un’altra domani nello stesso contesto. Il punto è assumere la responsabilità di quella scelta dire, Io ieri ho fatto A invece di B. Giustifico perché ieri ho fatto quello magari oggi mi sono reso conto che ieri ho sbagliato, in questo l’etica può essere scientifica nell’accettare l’errore . Molti parlano della scienza come un insieme di conoscenze certe. Alcuni dicono la scienza non ha sempre ragione, ma la scienza non ha mai ragione. È proprio per quello che è scientifica. Come approccio è un po popperiano. Un vero scienziato è ben contento di essere criticato perché se c’è qualcuno che arriva da lui dicendo: “no avevi torto!” Va bene. La scienza va avanti. Poi c’è l’aspetto umano dove ci si radica sulla propria convinzione.

MM: Certo, in questo modo hai un po’ risposto anche alla prossima domanda che era: può esistere a tuo parere oggettività o scientificità nell’etica?

EP: La scientificità la metterei dal punto di vista dei processi Nel senso che se con scientificità vuoi avere sempre lo stesso livello di qualità di scelta etica, in maniera quantitativa, direi che è una perdita di tempo. Perché la stessa scelta che fai sulla popolazione oggi cambia domani perché è cambiata la popolazione. Perché l’atteggiamento dopo il me too è stato diverso rispetto a quello precedente il me too, perché è cambiata l’accettabilità della scelta etica dal punto di vista della popolazione. Per cui c’è un problema di accettabilità. Poi c’è un problema di preferibilità Nel senso che, in quanto eticisti, o in quanto persone lungimiranti, uno potrebbe dire: la popolazione accetta che io maltratti un immigrato. Però io cerco di fare qualcosa in più di quello che la popolazione accetta Perché vedo al di là di questo. Cioè c’è una spinta positiva al cambiamento e io sono ottimista su questa cosa. L’umanità ha delle spinte positive in avanti, poi ogni tanto rallenta però tante cose sono state superate, sono state trasformate. La schiavitù esiste ancora nel mondo ma è vista in maniera negativa ovunque.

MM: Come dire è oggettivo ed è scientifico che l’etica si trasforma e che non è fissa. Ecco questo possiamo darlo per assodato: noi non siamo immobili, quindi trasferire i nostri valori in una macchina diventa anche in un certo senso impossibile. Per quello esistono sistemi di monitoraggio e controllo che devono essere dinamici anch’essi, in un certo senso. Chiuderei con questa domanda: ci puoi fare qualche esempio di buone pratiche o di Bluewashing così lo definisce anche Floridi? Ho fatto una ricerca sull’etica nell’IA e così ho visto che SOGEI sta facendo una campagna etica. Un po’ tutti stanno facendo progetti sull’etica, ma visto quello lì ho capito che il senso è fondamentalmente marketing. SOGEI propone una comunicazione del piano industriale 2021-2023, dove dicono tutta una serie di cose vaghe sull’etica e fondamentalmente, visto che lavorano soprattutto con la pubblica amministrazione, serve a dire:- noi siamo bravi e dateci soldi a noi, insomma! Mi sembra puro marketing. Uno dei casi di applicazione di ethics washing, come si chiama, Bluewashing.

EP: Si, quando c’è comunicazione esterna è spesso così. Perché i comitati fanno più il marketing che dei contratti etici, quindi dicono delle banalità, hai perfettamente ragione. Vorrei anche parlarti degli altri rischi sistemici che individua Floridi. Di uno te ne ho già parlato ed è l’ethics shopping cioè andare a prendere i concetti e principi che mi interessano nel momento in cui tu fai una carta etica. Invece se lo comunichi solo o quando lo comunichi e non lo applichi stai facendo ethics washing, Blue washing chiamato da Floridi nella differenza che c’è tra verde e blu e aveva scritto un libro Il verde e il blu e l’ha dedicato a questo. Dopodiché c’è il lobbing etico. Per esempio investire per fare lobbing all’interno dell’Unione Europea per evitare che l’Unione Europea inserisca nella legislazione dei principi che sono contrari a quello che vuoi fare. E questo anche negli standard. Io sono una grande azienda, ti pago per andare alla comunità europea e dire non mettetelo l’obbligo del comitato etico nelle aziende. Poi, visto che l’etica funziona per meccanismi, a volte non c’è la parola etica in mezzo però, per esempio, lavorare sui conflitti di interessi ha un impatto sull’etica. Non ridurre i conflitti di interessi in campo digitale vuol dire fare ethics lobbing perché stai facendo in maniera che che i conflitti di interessi non vengano ridotti. Quindi stai cercando di di influenzare i livelli più alti perché tu possa avere più tempo per fare quello che vuoi senza rispettare alcune norme che ti obbligherebbero avere un comportamento più etico.

MM: Si può dire che la Comunità Europea fissa degli standard anche di tipo etico, come ha fatto per la privacy per esempio, con il GDPR, che in un certo senso poi diventano degli standard globali.

EP: Allora, c’è una leggera precisazione da fare. La comunità europea fa leggi e regolamentazione. Poi gli stati nazionali messi assieme a livello internazionale, con ISO, fanno gli standard. Quindi UNINFO in Italia si occupa di standard per le tecnologie, a livello internazionale UNINFO fa parte di Iso per fare gli standard. C’è un livello intermedio che si chiama Cen-cenelec che a livello europeo si occupa di fare standard per le tecnologie e in particolare per l’intelligenza artificiale e il JTC 21 che è Joint Tecnical Comittee 21 che si occupa di intelligenza artificiale, l’Europa supporta la creazione di standard, ma non fa gli standard. Sono gli Stati nazionali che fanno gli standard assieme. Naturalmente li supporta perché lo standard è una maniera di applicare in un certo modo una legge e uno standard cerca di portarti a rispettare una legge. Quindi la Comunità Europea non fa standard, però ha come visione geopolitica il fatto di diventare lo standard setter, cioè l’area geopolitica mondiale dove gli standard per le tecnologie vengono lanciati. Ecco perché la UE ha fatto una legislazione su GDPR la legislazione è applicata e implica rispetto di alcuni principi etici che sono quelli per esempio dalla privacy che è un principio etico ma non c’è in tutto il mondo, in Europa c’è. L’identità digitale è un principio europeo. Poi possono essere fatti degli standard per allinearsi a questa legge. Poi ti parlavo degli ultimi due rischi sistemici (1) che avevano citati da Floridi so che ci siamo e sono il dumping etico e l’elusione etica. Allora l’elusione dell’etica. Semplicemente dici: nella nostra azienda faremo etica. Dopodiché i progetti più importanti passano avanti rispetto all’applicazione di alcuni principi e piano piano eviti di rispettare le tue Guide Lines, le regole interne, la carta etica. Oppure in alcune società dicono guarda, c’è quella persona che ha avuto un burnout e non sappiamo cosa farle fare, le mettiamo a fare il responsabile etico, così, a fare delle cose che non servono a niente. Quindi, se tu stai incaricando delle persone che sono già in difficoltà, è normale che poi avrai dei problemi. Poi c’è il dumping etico, che è il dumping classico. Nel senso che tu per esempio in Europa non puoi allenare un modello a riconoscere le razze, non lo puoi allenare, perché è vietato dalla legge. Per cui cosa fai? Tu fai il tuo centro di ricerca in una parte del mondo dove tu puoi allenarlo a riconoscere le razze. Quello che importi poi è il modello, non è il processo. Quindi esternalizzi la ricerca e importi l’output. Ma questo è quello che fanno anche negli OGM. La ricerca zozza la fai all’estero e porti il seme che funziona. Ma la ricerca non la fai in Europa. Questi sono i rischi sistemici. I rischi individuali invece sono il fatto di mettere un eticista da solo in una società enorme. E’ ovvio che non può lavorare. Devi essere, in quanto eticista, molto attento ai rischi etici nei quali incorri e molto attento a non essere tu a divenire un rischio lo stesso. Ma i rischi esistono sempre. Quelli individuali sono forti in questo momento sull’ IA. C’è un forte pressione dalle aziende per fare delle cose, per rispondere a dei problemi e quindi devi tener duro per per continuare a dare i tuoi consigli correttamente.

NOTE

1) (1) lo shopping etico, (2) il bluewashing etico, (3) il lobbismo etico, (4) il dumping etico e (5) l’elusione dell’etica. (Floridi 2022, p 166)